Vom Rauschen bis zum Kunstwerk – Wie funktioniert ein Diffusionsmodell?

In der Vergangenheit haben wir angeschnitten wie Sprachmodelle funktionieren und das diese grob umfasst eigentlich nur die nächsten Wörter basierend auf dem bereits gesagten voraussagen. Aber hast du dich je gefragt wie KIs eigentlich Bilder erzeugen?

Stell dir vor, du hast mühevoll ein Bild gezeichnet nur um es dann mit einem Radierer zu zerstören, so lange bis nur noch wirres Rauschen übrig bleibt. Und dann musst du aus diesem Rauschen, genau umgekehrt wieder alles sauber herauszuzaubern: Schritt für Schritt die Details zurückholen, bis aus dem Chaos wieder ein beeindruckendes Kunstwerk entsteht, und das immer und immer wieder. Genau das macht ein Diffusionsmodell.

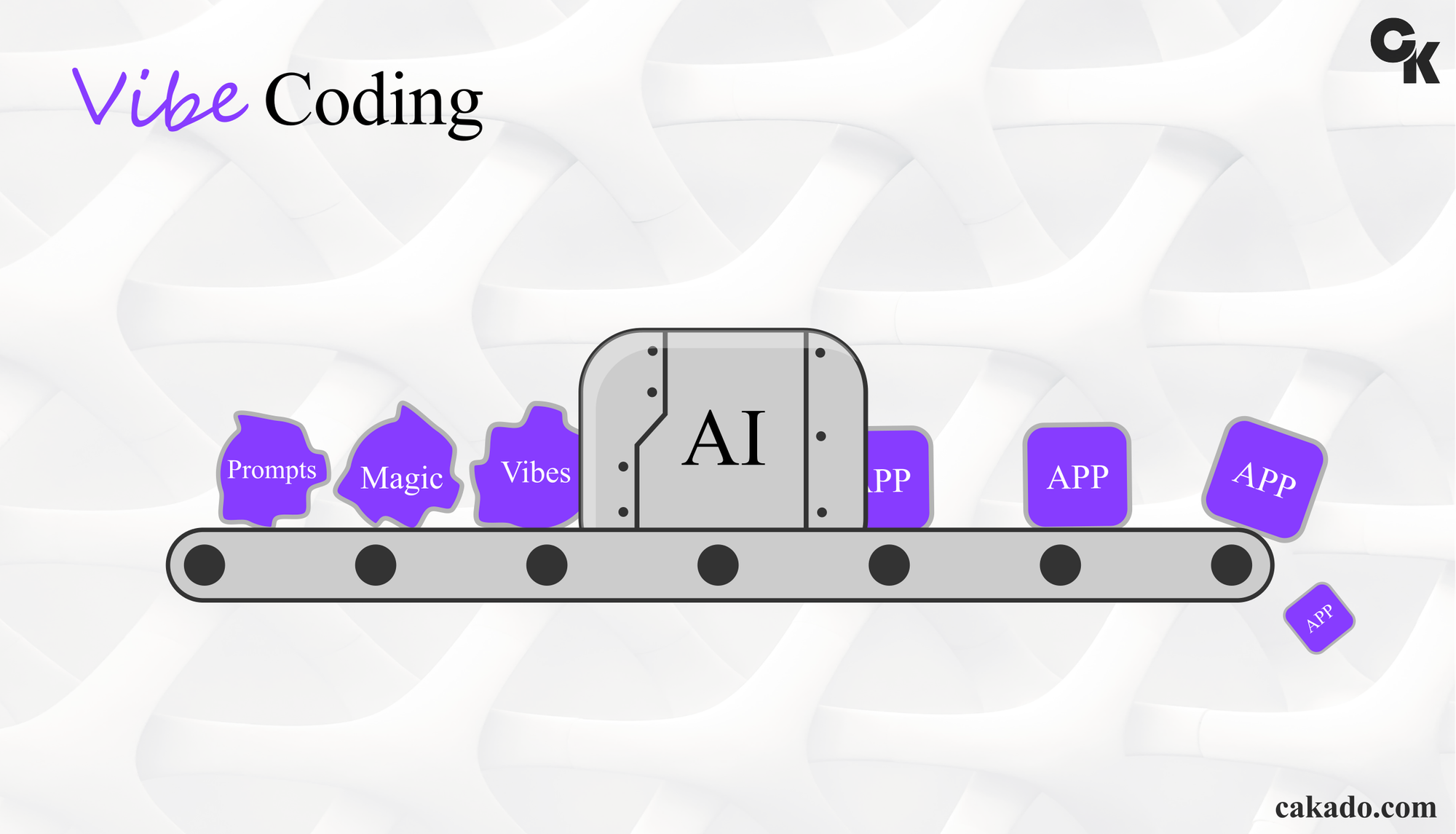

Im Kern geht es darum, echte Bilder in winzige Puzzleteilchen aus Rauschen aufzulösen und anschließend zu lernen, wie man diese Puzzleteile wieder zusammensetzt. In der ersten Phase – dem Vorwärtsprozess – wird ein Foto oder eine Illustration mehrfach verrauscht. Bei jedem Schritt kommt ein wenig mehr „Zufall“ hinzu, bis das ursprüngliche Motiv kaum noch zu erkennen ist. Du kannst es dir wie einen immer stärker verwischten Wasserfarben-Anstrich vorstellen. Dann kommt der spannende Teil: der Rückwärtsprozess. Hier wird ein neuronales Netzwerk darauf trainiert, genau dieses Rauschen zu durchschauen und systematisch zu entfernen. Es lernt, wie echte Bilder typischerweise aussehen – welche Formen, Farben und Strukturen zusammengehören. Dafür erhält es beim Training unzählige Beispiele, bei denen der Computer bereits weiß, wie das Bild vor dem Verrauschen aussah. So erkennt er Muster, die ein Foto oder eine Zeichnung „realistisch“ machen.

Rückwärtsdiffusion: Ein trainiertes Modell entfernt das Rauschen Schritt für Schritt und rekonstruiert daraus ein realistisches Bild.

Nach dem Training kannst du das Modell anstoßen, indem du es mit reinem Rauschen fütterst, also praktisch dem leeren Blatt Papier, das komplett zufällig ist. Schritt für Schritt entwirft das Programm daraus ein neues Bild – beispielsweise einen Sonnenuntergang am Strand, einen Comic-Helden oder eine surreale Landschaft. Alles entsteht aus dem Nichts, nur basierend auf dem, was das Modell gelernt hat.

Ein weiterer Vorteil sind sogenannte Guidance-Mechanismen, mit denen du das Ergebnis steuern kannst. Du gibst dem Modell zum Beispiel den Hinweis „male mir einen Drachen im Stil einer alten Holzschnitt-Illustration“. Dann nutzt es seine erlernten Bildstatistiken, um etwas zu erzeugen, das genau dazu passt.

Warum ist das Ganze so faszinierend? Weil Diffusionsmodelle unglaublich flexibel sind: Sie können nicht nur Bilder, sondern auch Musik oder Sprache erzeugen und sogar verrauschte Audiodaten wiederherstellen. Sie spielen eine große Rolle in aktuellen KI-Systemen wie Stable Diffusion oder DALL·E 2 und treiben die kreative Zusammenarbeit zwischen Mensch und Maschine voran. Man kann im Prinzip sagen, dass jede Art von digitalen Medien von einem dafür trainierten Modell erzeugt werden kann.

Am Ende entsteht etwas, das aussieht wie handgemachte Kunst, obwohl es komplett algorithmisch erzeugt wurde. Und das alles, weil ein cleverer Trick aus der Physik – die Idee des langsamen Vermischens und anschließenden Entmischens von Teilchen – auf moderne KI umgemünzt wurde. Ein kleiner Ausflug in die Welt der Diffusion, der hoffentlich Lust macht, selbst mal kreativ mit KI zu experimentieren!

Quellen: